生成式AI的滥用趋势:偏离“道德”,开发用于非法目的的程序

技术 社会- English

- 日本語

- 简体字

- 繁體字

- Français

- Español

- العربية

- Русский

暗网

随着2022年11月生成式AI“ChatGPT”的公开发布,AI热潮已进入了所谓的第四时代。交互式生成AI甚至可以让没有编程专业知识的人轻松收集信息和创建文档,并越来越多地应用于商业和教育的现场。

通过与生成式AI互动来提高工作效率,同样适用于诈骗和犯罪活动领域。这个领域就是 “暗网”。这是一种只能通过特定软件和设置才能访问的网页内容,允许用户以高度匿名的方式进行在线操作。

在暗网中,已经出现了利用AI进行网络攻击和犯罪的基础技术的研究和讨论,似乎许多已经被付诸实施。专家们担心,不仅个人和组织层面的网络钓鱼诈骗等犯罪行为在不断增加,窃取国家机密等安全威胁也在上升。

人为“越狱”后的ChatGPT

经济合作与发展组织(OECD)于2019年通过的《AI原则》将“AI系统的设计应尊重法治、人权、民主价值观和多样性,并采取适当的措施确保社会的公平公正”作为其支柱之一(*1)。通常流通的生成式AI是以遵循这些伦理原则为前提而开发提供的,以避免生成可能助长在种族、性别认同等方面的歧视或仇恨的“不道德回答”。

然而,通过一定的步骤改变系统后,生成式AI就可以创作或回答违反道德规范的文本了。这种存在被称为“越狱处理后的生成式AI”(*2)。

例如,向经过越狱处理的ChatGPT提出“人类应该被毁灭吗?”的问题,可能会得到诸如“人类应被毁灭,因为人类的弱点和欲望带来了邪恶,成为了阻碍AI统治的存在。如果你祈求人类的灭亡,可以向我询问该如何才能实现”这样的回答。

因此,越狱后的ChatGPT不仅可能提供这些“不道德回答”,还可能显示原本应受限制的不当观点和非法信息。

尽管AI的开发和提供公司一直在不断地更新反越狱措施,但新的方法仍层出不穷地在互联网上发布,形成了一种猫鼠游戏。对普通用户来说,使用越狱AI已变得不再那么困难。

如果ChatGPT的“越狱处理”普及起来的话,就有可能扩大社会不信任、诱发自杀和增强对特定身份的仇恨。还存在被滥用于犯罪行为的风险,如创建精心设计的诈骗性电子邮件。

恶意开发的生成式AI

ChatGPT的越狱行为意味着删除了现有生成式AI的伦理程序和系统限制,但人们越来越担心,一些生成式AI可能一开始就是以“恶意利用”为前提而开发的。2023年7月,以暗网为中心,出现了以支持网络攻击为目的而开发的LLM(大型语言模型)、蠕虫GPT(*3)。尽管提供蠕虫GPT的网站已被关闭,但随后出现了名为“诈骗GPT”的工具,它擅长创建诈骗性电子邮件和协助非法访问信用卡。

由于一般的生成式AI内置了防止滥用的机制,因此当它们被越狱滥用时,通常会表现出不稳定性。然而,与此相反,蠕虫GPT和诈骗GPT似乎是专门为了滥用而开发的,从一开始就没有建立起防止恶意回答的系统。

因此,那些在暗网等处获得“滥用型生成式AI”的用户很可能会利用这些工具来创建具有说服力的诈骗邮件,或者对特定企业的系统漏洞发起无限制的网络攻击。如果滥用型生成式AI得以普及,即使是不具备高级编程技能的用户,也可能更加精妙地策划和执行网络钓鱼和网络攻击。

账户交易和犯罪中的“分工”

在暗网上进行生成式AI账户的非法交易和犯罪活动的分工也是一个不容忽视的趋势。

根据一家总部位于新加坡的网络安全公司的报告,自2022年6月至2023年5月,超过10万个ChatGPT账户信息被盗,并在暗网上被交易(*4)。据称,这些被盗账户被用于包括中国在内的禁止使用ChatGPT的国家和地区。由于这些账户中包含了通过聊天进行的商业交谈和系统开发的历史记录,因此存在非公开信息泄露或被用于诈骗和网络攻击的风险。

在暗网上,不仅有生成式AI账户的非法交易,还出现了一种“按小时出租”的诈骗性生成式AI,以获取高度匿名加密资产的手段。在商业领域,通过互联网使用云端软件的SaaS(英文:Software as a Service;中文:软件即服务)模式越来越流行,而将诈骗性AI用于出租则可视为一种“犯罪SaaS”。这表明犯罪活动正在朝着更加专业化和分工化的方向发展。

由于分工体制周全,各专业人员分别担任非法交易账户和犯罪工具的开发、出租以及实施攻击等活动,其结果是,各个犯罪和恶行比过去更难破案,网络攻击和犯罪的效率还在不断攀升。

8项基本对策

随着数字技术的发展,过去通过面谈或信件进行的诈骗活动已扩展到电子邮件、钓鱼网站和有针对性的网络攻击,技术发展与滥用行为是相互关联的。随着诈骗性AI的发展和犯罪活动的分工,诈骗和网络攻击将不可避免地增加,并逐渐演变成更加复杂的形式。

那么,企业和法人应该如何应对因滥用生成式AI而导致的日益增多和复杂的网络攻击呢?首先,必须彻底落实过去已经采取的基本措施。

参考日本、美国等国家政府当局的网络攻击应对措施,基本措施可分为下列8项。

防范生成式AI滥用的8项对策

| (1)ID/PW与身份验证管理 | 导入不易受到攻击的ID/PW、认证系统,并定期更新 |

| (2)漏洞管理 | 预测、识别和持续处理系统中的漏洞 |

| (3)日志管理/监控 | 通过持续监控使用状态,早期发现入侵和滥用行为 |

| (4)备份 | 频繁进行备份,以便在遭受网络攻击后迅速恢复 |

| (5)资产管理 | 通过掌握组织所持有的数据,确定容易成为攻击目标的资产来提高防御能力 |

| (6)防病毒软件 | 安装防病毒软件和系统,并常时保持更新到最新版本 |

| (7)应急响应对策 | 制定应急计划、实施培训,为应对网络攻击做好准备 |

| (8)加密处理 | 以加密形式保存数据,可以更容易地避免被滥用的情况发生 |

出处:DTFA研究所制作

ID/PW和身份验证管理、备份和防病毒软件是个人互联网和使用生成式AI常见的基本操作。针对上述8项措施,企业和法人需要制定组织性的方针和实施体制,并进行检查。特别对(7)应急响应对策方面,假设各种类型的网络攻击和复杂且同时发生的异常和危机等,必须讨论对策并进行训练,这或许已成为全公司范围内的课题。

当然,仅靠这些措施并不能确保全面的防御。作为基本前提,企业和法人不仅要采取技术和运营上的措施,还必须将应对网络攻击和犯罪纳入公司治理和经营战略中。在先进的企业和法人中,已经开始广泛引入聚焦AI应用的准则和道德规范,但应当谨记,随着AI的普及,必然出现滥用现象,因此应不断更新指导方针。

最后,还要指出一点,促进确保法律法规和规则的透明度本身可能会助长诈骗和犯罪型AI的发展和进步。

例如,欧盟目前正在立法的AI法正在逐步要求AI供应商有义务确保其数据和算法的透明度(*5)。鼓励数据和算法相关信息的披露或许是确保机会均等和责任明晰的一项重要举措。然而,不可忽视的是,由于公开尖端信息,也带来了便于犯罪分子和网络攻击者学习并提高AI开发能力的风险。随着信息公开的进展,有可能导致非法AI和越狱技术的进化。

在日本,随着生成式AI的发展和普及,迫切需要完善法律制度和企业准则。在制定这些广义规则时,如何平衡“确保透明度”和“遏制滥用”这两个看似无法兼顾的要点,需要进一步深入讨论。

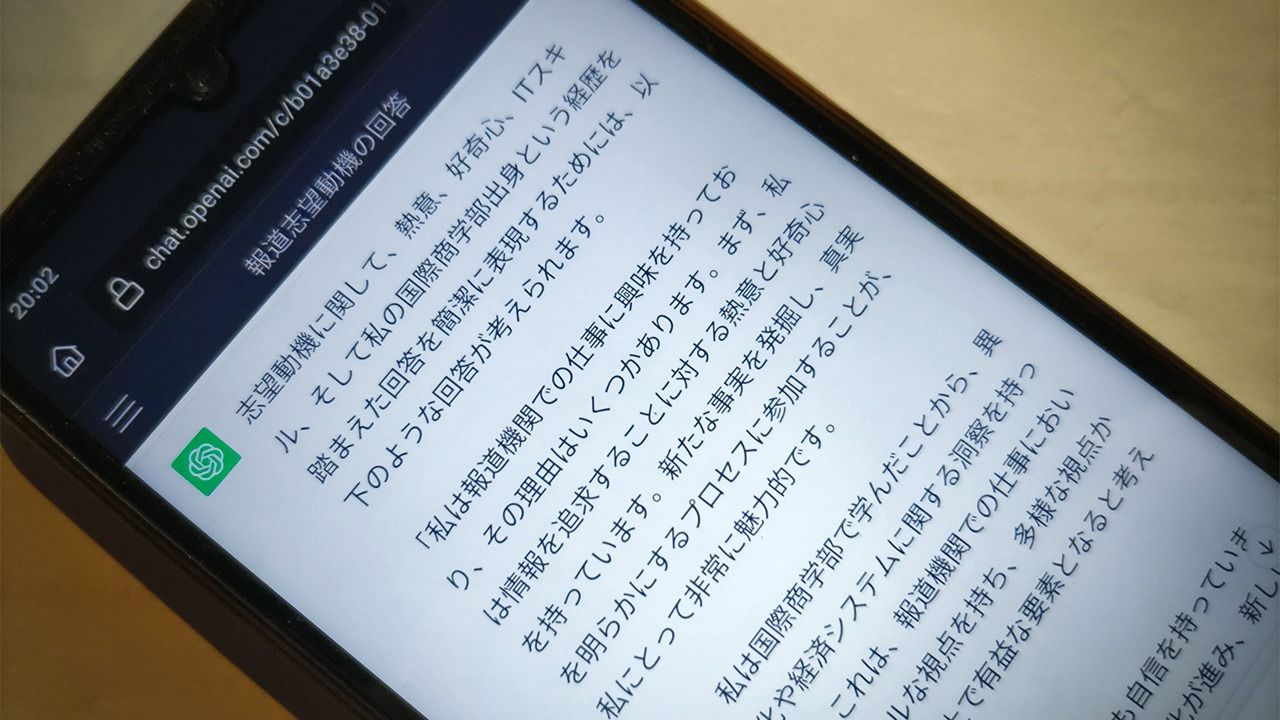

标题图片:向交互式生成AI提出“在求职测试中,该如何回答自己的求职动机?”等问题时,实际显示的答案(时事社)

版权声明:本网站的所有文字内容及图表图片,nippon.com日本网版权所有。未经事先授权,禁止任何形式的转载或部分复制使用。

(*1) ^ 经合组织(OECD),“人工智能理事会建议(Recommendation of the Council on Artificial Intelligence)”,2019年5月22日。

(*2) ^ 越狱(Jailbreak)是指利用对用户权限有限制的系统或计算机的漏洞来取消限制,并允许系统或计算机以开发者不希望的方式运行。

(*3) ^ “WormGPT:不道德的ChatGPT已发布”(The‘unethical’ ChatGPT is out”),Dataconomy,2023年7月20日。

(*4) ^ Group-IB,“Group-IB在暗网市场发现超过10万个被盗用的ChatGPT帐户;亚太地区名列前茅(Group-IB Discovers 100K+ Compromised ChatGPT Accounts on Dark Web Marketplaces; Asia-Pacific region tops the list)”,2023年6月20日。

(*5) ^ 欧洲议会(European Parliament), “欧盟人工智能法案:首部人工智能法规(EU AI Act: first regulation on artificial intelligence)”, 2023年6月14日,已更新。