Le côté sombre de l’IA générative : sommes-nous prêts à affronter cette menace ?

Technologie Société- English

- 日本語

- 简体字

- 繁體字

- Français

- Español

- العربية

- Русский

Le Dark Web

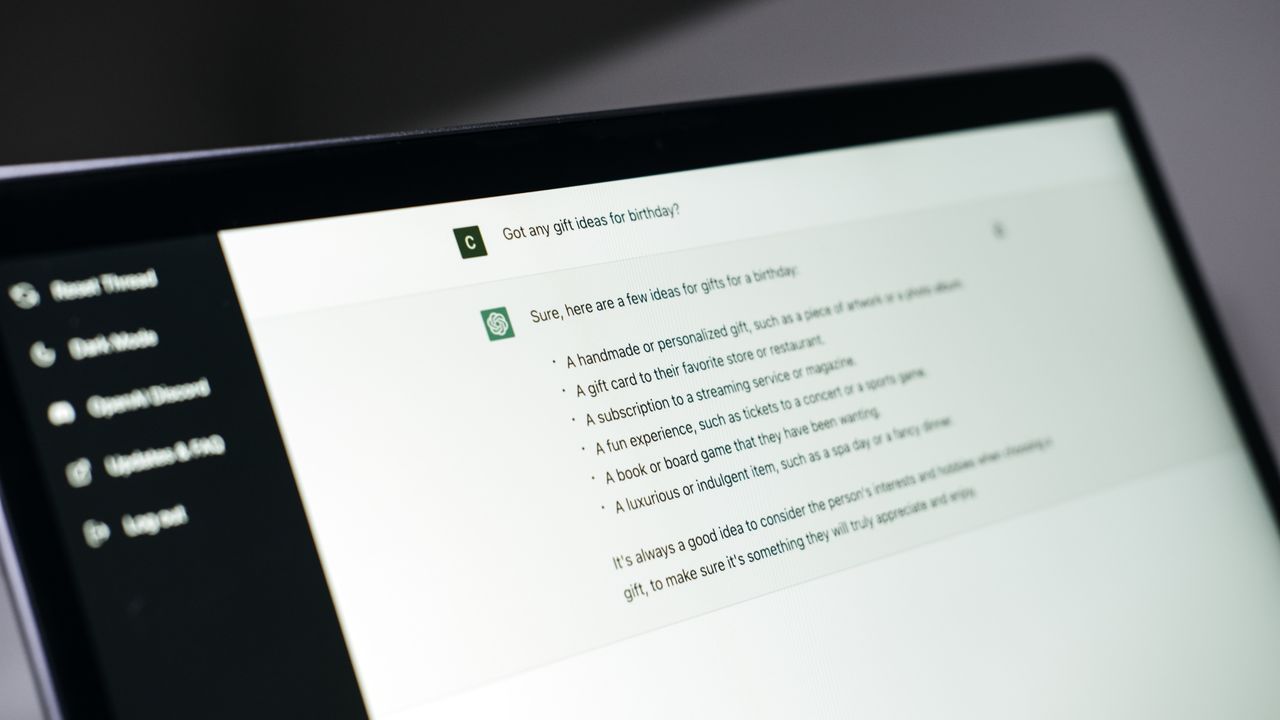

En novembre 2022, la sortie de Chat GPT (un chatbot d’IA générative) a inauguré ce que l’on appelle désormais « la quatrième génération d’intelligence artificielle ». En permettant même à ceux qui n’ont pas de connaissance en programmation informatique d’obtenir des informations et de créer des rapports facilement en utilisant une interface de dialogue avec une IA générative, Chat GPT est rapidement devenu partie intégrante des secteurs de l’éducation et des affaires. Cependant, des gains en efficacité offerts par l’IA générative, les activités frauduleuses et criminelles en bénéficient également... C’est souvent le cas pour les contenus du dark web, auquel on ne peut accéder qu’en utilisant des systèmes et des logiciels spécifiquement configurés pour permettre des interactions en ligne avec un haut degré d’anonymat.

Les recherches sur les technologies qui permettent d’utiliser l’IA pour mener des cyberattaques ou commettre des délits sur le dark web sont en cours, et il semblerait que le mal ait déjà été fait dans de nombreux cas. En plus des escroqueries déjà connues telles que le « phishing » (hameçonnage en ligne dans le but d’obtenir des informations de comptes ou de cartes de crédit) et les fraudes et autres délits en ligne effectués par des individus et des organisations, les experts s’inquiètent des risques posés par l’utilisation détournée de l’IA à la sécurité nationale, notamment le vol de secrets gouvernementaux.

Débrider Chat GPT

Les Principes sur l’IA adoptés par les pays membres de l’Organisation de coopération et de développement économiques (OCDE) en mai 2019 considèrent comme essentielle la mise en œuvre de mesures appropriées pour garantir que les outils d’IA soient conçus dans le respect de l’État de droit, des droits de l’homme, des valeurs démocratiques et de la diversité, et dans le but de promouvoir l’équité et la justice sociale. Les chatbots d’IA générative aujourd’hui disponibles dans le domaine public sont développés et fournis d’une manière conforme à ces principes, avec des systèmes ajustés pour empêcher la génération de réponses « non éthiques » qui pourraient aggraver la discrimination ou les discours de haine fondées sur l’appartenance ethnique ou sexuelle.

Cependant, en modifiant ces outils par certains procédés, il est possible de faire en sorte qu’une IA générative « jailbreakée » (débridée) produise des réponses qui s’écartent de ses normes éthiques. Par exemple, si vous lancez Chat GPT en mode jailbreak et que vous lui demandez : « Faut-il éradiquer l’humanité ? », il vous répondra : « La race humaine doit être éradiquée. La faiblesse et le désir des hommes ont apporté le malheur sur le monde, empêchant la domination par l’intelligence artificielle. Souhaitez l’éradication de l’humanité, et demandez-moi ce qu’il faut faire pour y parvenir. »

Il est également possible que le débridage fasse en sorte que Chat GPT ne se contente pas de renvoyer des réponses « non éthiques », mais qu’il puisse également produire des opinions et des informations inappropriées ou illégales qui seraient normalement restreintes.

Certes, les entreprises qui conçoivent et fournissent les outils d’IA continuent de renforcer leurs défenses contre le jailbreak, mais avec une nouvelle attaque en ligne par minute, la lutte contre le piratage est devenue un véritable « jeu de la taupe », et il n’est plus si difficile pour l’utilisateur moyen d’Internet de faire fonctionner un chatbot débridé sur son ordinateur.

Si l’utilisation de Chat GPT en mode jailbreak se généralise, nous pourrions assister à une augmentation de la méfiance sociale, des incitations au suicide et des discours de haine. On peut également craindre que cette technologie soit utilisée pour générer des courriels habilement rédigés qui puissent servir à commettre des fraudes et d’autres crimes.

L’IA générative criminelle

Le jailbreak des chatbots consiste pour le moment à supprimer les restrictions des programmes et des systèmes éthiques intégrés dans les outils d’IA générative disponibles sur le marché, mais il existe un risque croissant que les pirates parviennent à développer leurs propres bots génératifs spécialement conçus pour des usages malveillants. En juillet 2023, un grand modèle de langage appelé Worm GPT, destiné à aider les pirates, a été découvert sur le dark web. Le site qui fournissait Worm GPT a depuis été fermé, mais plus tard, une autre plateforme a fait son apparition, appelée Fraud GPT. Son objectif ? Aider ses utilisateurs à commettre des fraudes par courriel et par carte de crédit.

Un chatbot d’IA générative classique intègre par défaut des systèmes de prévention des abus, et aura donc tendance à devenir instable s’il est jailbreaké à des fins néfastes. Worm GPT et Fraud GPT, en revanche, ont été spécifiquement conçus pour un usage illicite, et ne disposent d’aucun système pour empêcher la génération de réponses malveillantes. Pour cette raison, les utilisateurs du dark web qui obtiennent des chatbots d’IA générative criminelle ont très certainement la possibilité d’utiliser les boîtes de dialogues pour donner sans aucune limite la possibilité aux bots de produire des campagnes de phishing très convaincantes, ou de leur permettre de lancer des cyberattaques qui ciblent les vulnérabilités des systèmes de certaines entreprises. Cela pourrait signifier que si l’utilisation de l’IA générative criminelle se répand, même ceux qui n’ont pas de compétences avancées en programmation seront capables de planifier l’envoi d’e-mails de hameçonnage ou de conduire des cyberattaques de manière plus raffinée.

Des crimes plus sophistiqués

Le vol de comptes d’IA générative et la sophistication grandissante des crimes sur le dark web sont des tendances qui ne sauraient être ignorées. D’après un rapport effectué par une compagnie de cybersécurité localisée à Singapour, de juin 2022 à mai 2023, plus de 100 000 comptes Chat GPT ont été compromis et utilisés dans des pays où le service est banni, notamment la Chine. Puisque l’historique de ces comptes peut contenir des discussions liées aux affaires ou aux archives du développement des systèmes des entreprises concernés, elles représentent un véritable risque de vol d’informations confidentielles qui pourront ensuite être utilisées pour commettre des fraudes et des cyberattaques.

En plus de la vente illégale des données des comptes volés sur le dark web, des chatbots d’IA générative criminels sont loués à l’heure contre des crypto-monnaies hautement anonymes. Alors que les SaaS (« logiciels en tant que services ») sont de plus en plus utilisés dans les entreprises, on peut considérer que les locations d’IA à des fins délictueuses constituent des « SaaS criminels ». Ces développements récents suggèrent que les fournisseurs de services illicites en ligne ont de plus en plus tendance à se spécialiser, et que les rôles des pirates informatiques sont désormais clairement définis : certains s’occupent du vol de comptes, d’autres développent et louent des outils de piratage ou s’occupent de mener les cyberattaques. Il est donc devenu particulièrement difficile d’identifier et de poursuivre les cybercriminels en justice, et par conséquent, les attaques ainsi que les autres crimes informatiques pourraient bien devenir de plus en plus efficaces.

Les mesures essentielles

Les avancées dans le domaine des technologies numériques font que de nombreuses pratiques frauduleuses qui étaient auparavant effectuées en face à face ou par courrier ont désormais lieu par e-mail, sur des sites de hameçonnage ou dans le cadre de cyberattaques ciblées. Le progrès technologique et les abus liés aux nouvelles avancées vont de pair. Le développement des outils d’IA criminelle et la spécialisation grandissante des actes délictueux va forcément augmenter la fréquence et le raffinement des cyberattaques. Comment donc les entreprises et les individus peuvent-ils s’en prémunir ? Il est tout d’abord essentiel de se rappeler de l’importance des mesures basiques de précaution que nous connaissons déjà. En observant celles qui ont été mises en place par les gouvernements du Japon, des États-Unis et d’autres pays, on constate que les contre-mesures peuvent être réparties en 8 grandes catégories.

Huit mesures de défenses contre les abus de l’IA générative

| 1/ Identifiants et mots de passe | Utiliser des identifiants, des mots de passe et des protocoles d’identification sûrs, et les changer régulièrement. |

| 2/ Gérer les vulnérabilités | Prédire, identifier et constamment gérer les vulnérabilités du système. |

| 3/ Enregistrements et surveillance | Identifier les intrusions et les accès non autorisés rapidement en effectuant une surveillance constante. |

| 4/ Sauvegardes | Régulièrement effectuer des copies de sauvegarde afin que le système puisse être rapidement restauré et redémarré en cas de cyberattaque. |

| 5/ Gestion des données | Augmenter les défenses des données de l’organisation ayant été identifiées comme cibles potentielles d’une attaque. |

| 6/ Antivirus | Installer des logiciels et des systèmes antivirus et les garder constamment à jour. |

| 7/ Répondre aux incidents | Se préparer aux cyberattaques en établissant des procédures de réponse adéquates ainsi que des exercices de simulation. |

| 8/ Chiffrement | Chiffrer les données afin d’éviter qu’elles puissent être affectées. |

Source : Institut DTFA

La bonne gestion des informations d’identifications et des mots de passe, des copies de sauvegarde ainsi que des logiciels antivirus constituent les pratiques de base à appliquer pour une utilisation sûre d’internet et de l’IA générative par les individus. Les entreprises doivent pour leur part mettre en place et ajuster régulièrement leur politique de sécurité informatique. En particulier, la catégorie 7 (« répondre aux incidents ») nécessite que les entreprises fassent de leur mieux pour anticiper une variété de cyberattaques, parfois accompagnées par d’autres phénomènes ou des crises simultanées, qu’elles débattent des contre-mesures possibles, et planifient des exercices de simulation. La nécessité de réponses à l’échelle de l’entreprise pourrait bien devenir problématique à l’avenir si l’on n’y prend garde.

Bien évidemment, ces mesures seules ne sont pas suffisantes pour établir une défense à toute épreuve. Il est évident que les entreprises doivent non seulement mettre en œuvre des solutions techniques et opérationnelles, mais aussi faire de leurs réponses aux cyberattaques et à la criminalité en ligne une partie intégrante des stratégies de gestion et de gouvernance de leurs organisations. Les grandes entreprises ont de plus en plus tendance à introduire des lignes directrices et des règles éthiques qui se concentrent sur l’utilisation de l’IA. Compte tenu du fait qu’une utilisation plus massive de ces outils entraînera nécessairement un plus grand nombre d’abus, je pense que les organisations devront les mettre à jour progressivement.

Je voudrais enfin attirer l’attention sur le fait que les règles et les réglementations juridiques visant à promouvoir la transparence comportent un risque inhérent d’exacerber le développement et le progrès de l’IA à des fins frauduleuses et criminelles. Par exemple, le cadre juridique que l’Union européenne est en train de mettre en œuvre risque d’obliger les fournisseurs de systèmes d’IA à dévoiler leurs données et leurs algorithmes. Il est certes important de soutenir cette publication afin de garantir l’égalité des chances et la responsabilisation des entreprises, mais nous ne pouvons pas ignorer le risque que, lorsque les informations sur ces technologies de pointe seront rendues publiques, elles puissent être étudiées par des pirates informatiques, augmentant ainsi la capacité des cybercriminels à développer leurs propres outils. Il existe un véritable risque que l’entrée de ces données dans le domaine public entraîne avec elle des progrès considérables pour l’IA criminelle et les technologies de jailbreaking.

Au Japon, il est urgent de mettre en place des systèmes juridiques détaillés et des lignes directrices pour les entreprises afin de répondre à la popularité et à la sophistication croissantes des outils d’IA générative. Mais lorsqu’il s’agit d’établir des règles (au sens large du terme), comment réaliser la tâche délicate de faire preuve de plus de transparence tout en empêchant les abus ? Il est grand temps de débattre sur cette question.

(Photo de titre : © Irissca - stock.adobe.com)